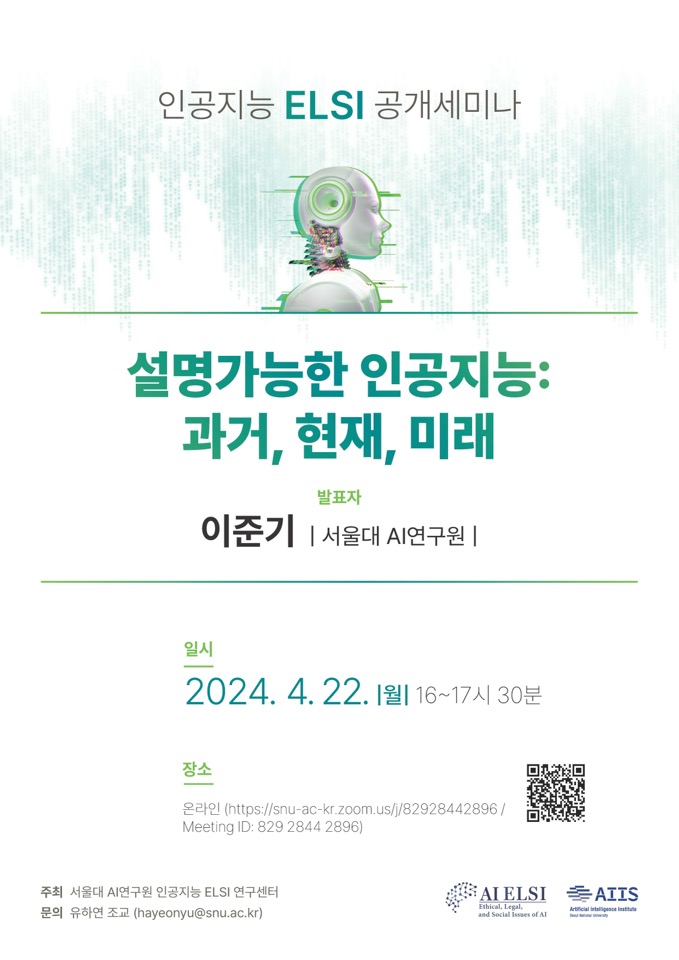

행사안내 인공지능 ELSI 공개세미나

본문

서울대 AI연구원 인공지능 ELSI 연구센터는 인공지능의 윤리적·법적·사회적 쟁점들에 관한 공개세미나 열고 있습니다.

이번에는 서울대 AI연구원의 이준기 박사님을 모시고 "설명가능한 인공지능: 과거, 현재, 미래"라는 제목으로 발표를 듣습니다.

인공지능의 불투명성이 문제로 인식되는 상황에서, 이번 발표는 인공지능의 투명성, 설명책임 등에 대해 생각해볼 수 있는 계기가 될 것입니다.

많은 관심과 참여 바랍니다.

일시: 2024년 4월 22일 월요일 16시-17시 30분

장소: 온라인(https://snu-ac-kr.zoom.us/j/82928442896 / Meeting ID: 829 2844 2896)

발표 제목: 설명가능한 인공지능: 과거, 현재, 미래

발표 초록: 인공지능은 규칙기반, 지도를 통한 기계학습 기반, 비지도 및 순차적 의사 결정 과정에 대한 기계학습 기반의 순으로 성장하고 있습니다. 본 발표에서는 각 인공지능 기법에 대한 이해를 넓히고 실생활에 적용되고 있는 사례 및 이에 대한 설명 방법에 대해서 다룹니다.

규칙기반 방법은 가장 오래된 인공지능의 방법이지만 가장 널리 사용되고 있으며 다양한 비디오 게임, 아마존의 알렉사와 같은 대화형 인공지능, 전문가 시스템으로 불리는 판단형 시스템 및 현세대의 자율주행 시스템에서 쓰이고 있습니다. 이와 같은 방법은 규칙에 기반하기 때문에 인공지능 에이전트의 판단을 설명하는데 있어서 그 기준을 설명하는데 큰 어려움이 없었습니다.

지도를 통한 기계학습 기반의 인공지능은 딥러닝 연산 기술의 발달과 함께 다계층의 비선형 함수를 중첩시킨 인공신경망으로 불리는 네트워크 형태를 가지며 통계적 경사 하강 기법으로 학습됩니다. 비선형 함수 및 통계적 경사 하강 기법이 가지는 성질로 인해 학습된 네트워크는 주어진 문제 전체에 대한 성능 지표로 대표될 수는 있으나 각각의 의사 결정 과정에 있어서 그 판단이 되는 기준을 설명하는데는 취약합니다. 지도학습으로 학습된 기계학습 분류기, 실수값을 예측하는 회귀분석 기법의 예측기, ChatGPT 및 Dall-E 등으로 대표되는 생성형 AI 등은 이러한 지도학습 방법의 취약성을 모두 갖고 있습니다. 지도 학습 방법의 대표적인 최약성과 이를 보완하는 다양한 설명 기법에 대해서 다루고 각각의 장단점에 대해서 다룹니다.

비지도 및 순차적 의사 결정 학습법 또한 딥러닝의 기술적 발달로 비약적으로 발전하고 있습니다. 최근 알파고의 인간과의 바둑 대결의 승리 등이 대표적인 예입니다. 본 발표에서는 순차적 의사 결정 방법과 기존의 의사 결정 방법의 차이에 대해서 설명하고 이를 설명하기 위한 다양한 방법들에 대해서 다룹니다. 또한, 이러한 방법들이 아직 실세계 적용되기 위해 해결되어야 하는 문제들을 기술합니다.

댓글목록

등록된 댓글이 없습니다.