장병탁 서울대 AI연구원장 "인공지능, 오감 익힐 신체 있어야 더 발달"

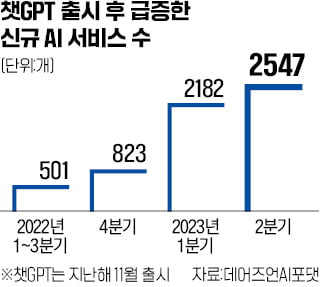

세계 최고의 자연어 처리 분야 연구자 중 한 명인 최예진 워싱턴대 컴퓨터공학과 교수는 최근 TED 강연에서 “초거대 인공지능(AI)이 상식을 갖추도록 추가 데이터를 계속 학습시키는 것은 빌딩을 계속 높이 쌓아 달까지 가겠다는 헛된 노력”이라고 지적하기도 했다.

장병탁 서울대 AI연구원장(컴퓨터공학과 교수)도 지난달 서울대에서 열린 그랜드퀘스트 오픈 포럼에서 “챗GPT류의 인공지능은 사상누각으로 지식을 쌓고 있는 것이나 다름없다”고 진단했다. 텍스트를 통해서만 정보를 축적하고 있기 때문이다. 챗GPT가 간혹 사용자 질문에 그럴듯하지만 전혀 사실과 다른 ‘환각’ 대답을 내놓는 이유도 여기에 있다고 장 원장은 설명했다.

그는 “AI가 열린 세계로 나아가기 위해선 외부와 상호작용할 수 있는 신체가 필요하다”고 말했다. 인간이 오감을 동원해 외부 세계와 능동적으로 상호작용하듯이 인간의 뇌와 같은 인지 구조를 갖춘 AI를 개발하는 데 역량을 집중해야 한다는 주장이다. 장 원장은 “오감이라는 센서를 통해 학습해 창발적인 지능이 나타나야 AI가 궁극적으로 세상을 이해할 수 있게 된다”고 분석했다.

서울대 AI연구원은 인지 구조를 지닌 AI를 구현하기 위해 ‘베이비마인드’ 프로젝트를 진행하고 있다. 8개월 아기의 학습 방식을 모방하기 위해 시청각 정보처리와 언어·감정 처리 등을 6개 그룹에서 동시에 연구 중이다.

김인엽 기자

한경-서울대 공대 공동 기획

-

기사 스크랩

-

공유

-

프린트

![서학개미 뒤집어졌다…다우지수 종가기준 첫 4만선 돌파 [뉴욕증시 브리핑]](https://timg.hankyung.com/t/560x0/photo/202405/AD.36579999.1.jpg)